Spark在MaxCompute的运行方式 一、Spark系统概述 二、Spark运行在客户端的配置和使用 三、Spark运行在DataWorks的配置和使用 四、Spark在本地idea测试环境的使用

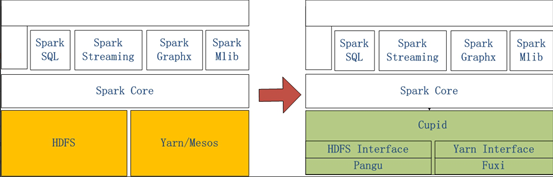

左侧是原生Spark的架构图,右边Spark on MaxCompute运行在阿里云自研的Cupid的平台之上,该平台可以原生支持开源社区Yarn所支持的计算框架,如Spark等。

二、Spark运行在客户端的配置和使用

2.1打开链接下载客户端到本地

2.2将文件上传的ECS上

2.3将文件解压

2.4配置Spark-default.conf

2.5在github上下载对应代码

https://github.com/aliyun/MaxCompute-Spark

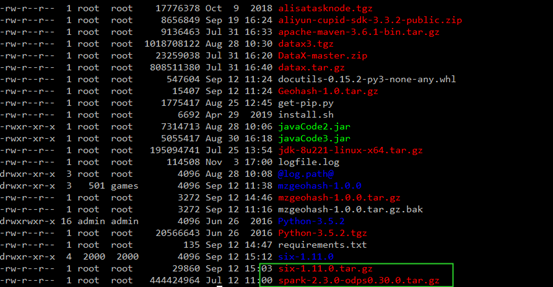

2.5将代码上传到ECS上进行解压

2.6将代码打包成jar包(确保安装Maven)

2.7查看jar包,并进行运行

三、Spark运行在DataWorks的配置和使用

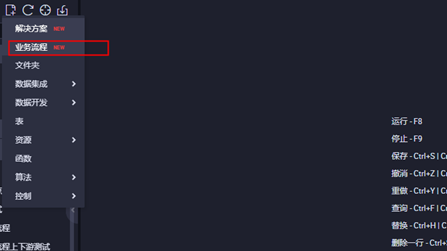

3.1进入DataWorks控制台界面,点击业务流程

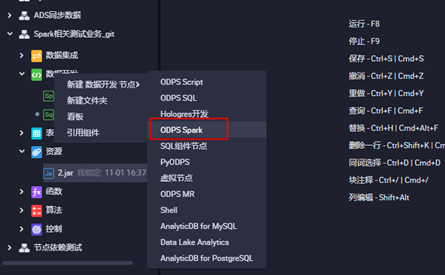

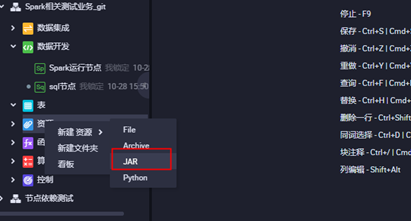

3.2打开业务流程,创建ODPS Spark节点

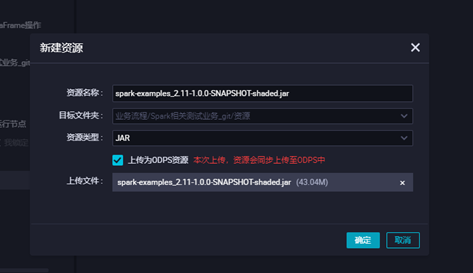

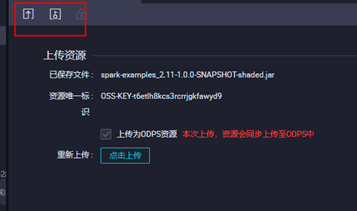

3.3上传jar包资源,点击对应的jar包上传,并提交

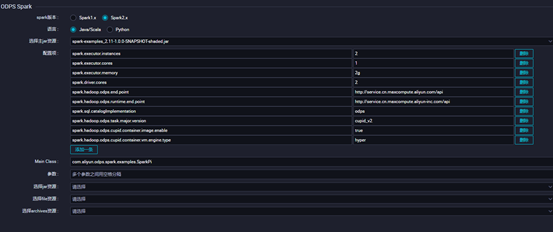

3.4配置对应ODPS Spark的节点配置点击保存并提交,点击运行查看运行状态

四、Spark在本地idea测试环境的使用

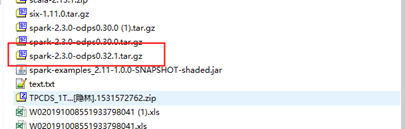

4.1下载客户端与模板代码并解压

模板代码:

https://github.com/aliyun/MaxCompute-Spark

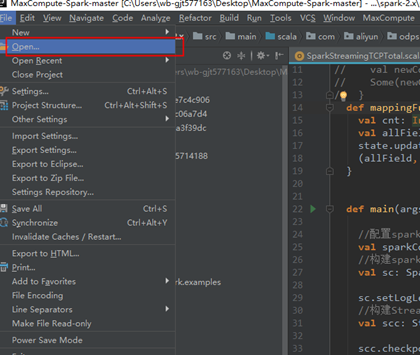

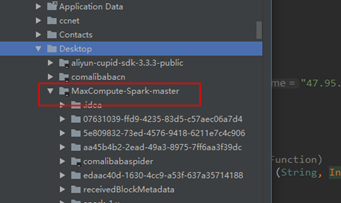

4.2打开idea,点击Open选择模板代码

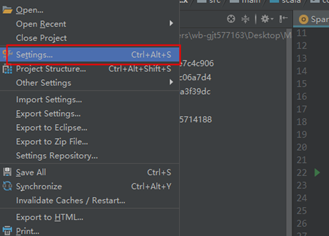

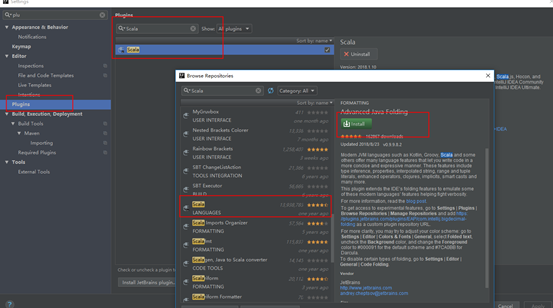

4.2安装Scala插件

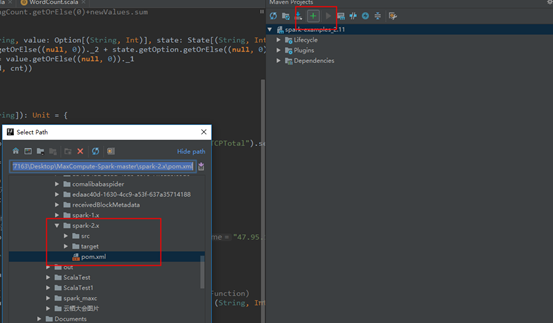

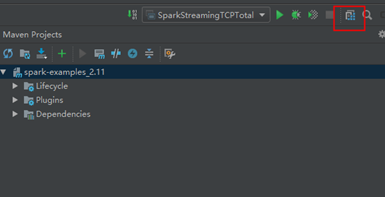

4.3配置maven

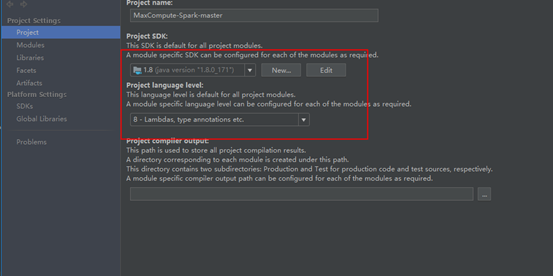

4.4配置JDK和相关依赖

本文作者:耿江涛

本文为云栖社区原创内容,未经允许不得转载。